La révolution des méthodes numériques pour les géosciences

Les méthodes numériques occupent une place centrale dans les géosciences, offrant aux scientifiques des outils puissants pour modéliser et comprendre les processus complexes de la planète Terre. Ces outils connaissent aujourd’hui des avancées spectaculaires.

Qu’il s’agisse de simuler l’évolution du climat ou de prévoir la dynamique des océans, les méthodes numériques modélisent des phénomènes impossibles à observer directement ou à reproduire en laboratoire. Elles reposent sur des modèles mathématiques traduits en algorithmes, exécutés grâce à des capacités de calcul toujours plus performantes. Longtemps limitées par la puissance des ordinateurs et la disponibilité des données, elles bénéficient aujourd’hui des avancées fulgurantes du calcul haute performance, de l’apprentissage automatique et des capteurs d’observation spatiale. Cette évolution ouvre la voie à des simulations plus réalistes, plus rapides et mieux adaptées à l’incertitude inhérente aux systèmes naturels. Ces techniques ne se contentent plus de décrire le passé ou le présent : elles testent des scénarios futurs, offrant aux scientifiques comme aux décideurs de nouveaux moyens d’anticiper les changements environnementaux et de guider les choix pour l’avenir.

La (nécessaire ?) montée en résolution

La quête de précision entraîne des défis majeurs dans le monde de la recherche et notamment en matière de résolution des modèles de climat. Des mailles plus fines sont nécessaires pour intégrer des phénomènes très localisés, améliorer la compréhension de certains processus biophysiques et obtenir des simulations plus robustes. Cependant, cela requiert également une montée en puissance de calcul et en quantité de données, qui s’accompagne d’un coût en temps et en énergie. Anne Cozic, ingénieure de recherche dans l’équipe Calculs du Laboratoire des sciences du climat et de l’environnement (LSCE – Univ. Paris-Saclay/CNRS/CEA/UVSQ), se rappelle les premières montées en résolution.

« À l’époque, nous avions parallélisé les codes », lance-t-elle en expliquant cette méthode qui répartit les tâches sur différents processeurs pour être exécutées simultanément, avec un gain de temps de calcul, de résolution, de complexité, ou bien de quantité de données traitées. « Cela demande tout un système de codage différent pour organiser le travail et la façon dont les données circulent, mais nous a permis de monter en résolution en maintenant des temps de calculs raisonnables », », précise Anne Cozic. Globalement, chaque processeur reçoit un bloc de la grille, et l’ensemble des processeurs travaille plus vite qu’un seul processeur.

Mais cette grille, qui découpe la Terre en longitude et latitude, est un problème à part entière : elle n’est pas régulière. Les mailles, plus ou moins carrées à l’équateur, se déforment aux pôles et engendrent des problèmes sur la rapidité des calculs, en rendant la parallélisation des codes moins efficace. « Il y a quelques années, une équipe a développé une nouvelle grille déstructurée, avec des tronçons en icosaèdres à la place des rectangles », dévoile l’ingénieure.

Cette approche de découpe d’une forme similaire à un ballon de foot est uniforme sur toute la surface du globe et de fait, plus facile à diviser sur plusieurs processeurs. « Cela a été utile à une étude de Zoé Lloret, [durant sa thèse], pour quantifier le budget des émissions de CO2 aux niveaux nationaux », illustre Anne Cozic. Grâce à cette nouvelle grille, les scientifiques ont parallélisé les codes et obtenu une résolution plus fine, nécessaire pour nourrir les stratégies d’adaptation des budgets nationaux, lorsque la découpe des régions dans les modèles ne suffit pas.

La génération GPU

« La prochaine génération va être très différente et va fortement monter en résolution », affirme la scientifique du LSCE. « Nous sommes en plein dans cet entre-deux. » Cette nouvelle génération de processeurs, ce sont les Graphics Processing Units (GPUs) ou processeurs graphiques, à l’origine développés pour l’exploitation des jeux vidéo. Ces technologies conçues pour les calculs mathématiques intensifs et nécessaires au rendu graphique et au calcul d’image se révèlent particulièrement utiles aux géosciences. La nouvelle génération de processeurs les utilise pour traiter plus de données et plus rapidement avant de les compiler sur une unité centrale de calcul (Central Processing Unit ou CPU) capable de traiter les tâches plus complexes de la simulation.

Cela signifie, pour tous les scientifiques qui travaillent sur des codes pensés pour les CPU, de faire un portage de leur code pour qu’il soit lisible et utilisable sur les GPU. « Certains groupes de travail s’activent pour créer un outil qui agirait avant la compilation des données [GPU vers CPU] pour réécrire le code et qui faciliterait la vie de tous les utilisateurs et utilisatrices », explique Anne Cozic. Selon elle, c’est un des grands avantages de faire partie d’une fédération de recherche (Institut Pierre-Simon Laplace) qui facilite les groupes de travail inter-laboratoires et développe des outils communs. « Il n’est pas facile de s’adapter et aujourd’hui, l’enjeu est là », insiste-t-elle. « Il va falloir que les utilisateurs et les utilisatrices s’adaptent à ces codes pour GPU. Et plus ces nouveaux codes sont complexes, plus le risque d’erreur est grand. »

La communauté des sciences de la terre travaille sur des outils similaires, comme les supercalculateurs sur lesquels tournent les modèles de climat. Le choix de l’Institut du développement et des ressources en informatique scientifique (Idris – Univ. Paris-Saclay/CNRS) de passer aux GPU implique pour les utilisateurs et les utilisatrices du supercalculateur de faire leur portage. Sans quoi, les équipes de recherche n’en exploiteraient qu’une toute petite partie. Pour autant, Anne Cozic maintient qu’il est crucial de se poser la question des besoins réels du projet et de considérer le coût énergétique. « Nos modèles de chimie atmosphérique comptent énormément d'espèces chimiques et sont très lourds - la montée en résolution n'est pas la priorité. À chacun et chacune de trouver la balance entre la puissance, le temps de calcul et le coût énergétique. »

Les paramétrisations et leurs biais

Les méthodes numériques apportent d’autres solutions pour intégrer les processus qui ne sont pas explicitement résolus par les modèles de climat, comme la formation des nuages dont l’échelle spatiale est bien plus fine que la maille des modèles, d’environ 100 kilomètres. Les scientifiques ont alors recours à des paramétrisations : des simplifications pour approcher les effets de ces phénomènes sur les variables du modèle. Elles impliquent des choix et créent de petites différences propres à chaque modèle, qui deviennent conséquentes en fin de simulation, notamment sur le bilan énergétique de la Terre. Soulivanh Thao, chercheur dans l’équipe Extrêmes : statistiques, impacts et régionalisation (Estimr) au LSCE, explique que « certains modèles, notamment d’impact ou d’hydrologie, sont très sensibles aux effets de seuils et la correction de biais devient alors critique ».

Pour contourner ces biais et obtenir des projections robustes, les modèles sont évalués et comparés sur la période historique, puis combinés ensemble pour optimiser un critère d’intérêt. Une autre méthode consiste à corriger chaque simulation de ses biais, en comparant ici encore les données du modèle aux observations historiques. L’agrégation de modèles et la correction de biais sont généralement abordées par des communautés distinctes, mais pourquoi ne pas combiner les deux ? L’alpha-pooling est une méthode de correction de biais statistique à travers la construction d’une fonction de distribution cumulative (CDF) calibrée sur la période historique. « L’attrait de cette méthode est qu’avec moins de paramètres et une procédure plus simple, il y a moins de place pour l’erreur et donc des projections plus robustes » précise Soulivanh Thao.

« Cela fait quelques années que nous essayons de développer des liens entre les variables ou les points de grille pour corriger plusieurs choses d’un coup » ajoute-t-il. « Ce type d‘approche serait d’autant plus utile pour de la correction multivariée. » Les méthodes traditionnelles univariées associent une variable à chaque grille du globe, et il arrive que cela ne garde pas de cohérence entre deux points adjacents. Ce concept original mélange les avantages des deux méthodes traditionnelles et les résultats se montrent prometteurs sur les modèles de référence.

Des méthodes populaires

Les modèles statistiques sont de possibles grands alliés pour l’obtention d’une résolution plus fine, notamment grâce aux méthodes de régression - des outils puissants pour l'analyse statistique et la prédiction. Ces méthodes sont capables de descendre d’échelle par rapport aux modèles globaux en modélisant les relations entre les variables de grande-échelle et les observations locales d’une variable recherchée, et évitent certains biais des paramétrisations. Les réseaux de neurones à convolution gagnent en popularité, notamment pour des cas non-linéaires où les méthodes classiques, comme les arbres de décision, montrent leurs limites.

Excellents en traitement de l’image, reconnaissance et classification, et capables de traiter énormément de données, les réseaux de neurones sont déjà adoptés hors de la communauté scientifique, par exemple pour des applications d’identification de plantes. « Ils sont bien adaptés aux grilles des modèles, traitent de grandes régions d’un coup et ont des résultats plus précis », explique le chercheur du LSCE. Les relations étant apprises sur la période historique, la question persiste de savoir si ces relations sont transférables aux projections futures. « Dans notre étude, les forêts de décision (APRFs) semblaient être les plus fiables vis-à-vis des projections », indique Soulivanh Thao.

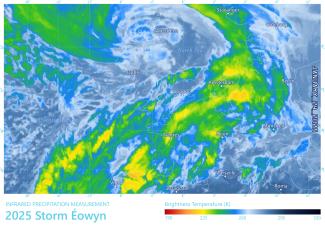

« Dans la correction de biais, nous corrigeons en général des variables physiques par rapport à l’ensemble des valeurs observées. Lorsqu’il s’agit de corriger un objet physique ou un événement météorologique très spécifique, c’est plus compliqué », détaille Soulivanh Thao. Les cyclones sont un obstacle particulièrement difficile à modéliser en raison de leur variabilité naturelle, de leur évolution rapide et de processus encore mal compris. Pour pallier ces problématiques, son collègue Davide Faranda a tenté une approche originale en définissant des métriques dynamiques liées à la persistance et la dimension locale des cyclones. Le concept est de trier les cyclones observés dans le monde réel et dans les modèles en différentes catégories et selon ces deux métriques, puis de corriger les champs de pression dans les modèles via les méthodes de correction de biais plus classiques. « Si on veut des représentations de cyclones plus réalistes dans les simulations, nous allons avoir besoin de ce genre de méthode, mais c’est encore très récent et nécessite beaucoup de développement », résume Soulivanh Thao.

Gros plan sur la pluviométrie

De manière générale, la modélisation de la pluviométrie comporte encore beaucoup d’incertitudes. « Il y a depuis quelques années des réflexions sur la mise au point d’outils de correspondance entre différents événements de précipitations. Le plus souvent, l’objectif est de faire ressortir l’information commune », annonce Aymeric Chazottes, chercheur au Laboratoire atmosphères, observations spatiales (Latmos – Univ. Paris-Saclay/CNRS/UVSQ/Sorbonne Univ.). Il mentionne une approche étudiée pour améliorer la détection et les prévisions sur le bassin parisien, en comparant des séries de pluie entre elles, en utilisant une version améliorée d’un algorithme, le Dynamic Time Warping (DTW). Le caractère itératif et multi-échelle de cette version du DTW affine petit à petit la résolution et évite des problématiques d’accrochage sur des détails qui ne sont pas pertinents à l’échelle globale pour l’amélioration des prévisions météorologiques.

Une autre approche s’attaque à la représentation au niveau de la goutte d’eau. La pluie est régie par des processus complexes dont certains sont étudiés en laboratoire par des spécialistes de la mécanique des fluides. Cela reste un phénomène aléatoire et difficile à mesurer, et dont certains phénomènes demeurent mal compris. Le chercheur du Latmos a participé à l’étude d’une nouvelle méthode capable d’estimer simultanément la distribution verticale de la taille des gouttes de pluie et les profils verticaux du vent lors d’événements pluvieux légers et stratiformes, grâce à l’assimilation de données. La démarche combine les mesures au sol d’un disdromètre, qui enregistre le flux de gouttes, avec les observations spectrales d’un radar Doppler pointé verticalement.

Le tout est exploité grâce à une technique d’assimilation de données appelée 4D-VAR (assimilation variationnelle en quatre dimensions). Couramment utilisée pour améliorer les prévisions météorologiques, cette méthode intègre simultanément les observations spatiales et temporelles à un modèle numérique, afin de déterminer l’état le plus probable de l’atmosphère. Selon Aymeric Chazottes, « la méthode a plutôt bien fonctionné, mais elle repose sur la simplification de nombreux problèmes complexes et ne prend pas en compte certains paramètres importants ». Les méthodes numériques apparaissent ainsi comme un outil essentiel pour mieux comprendre et expliquer la physique régissant les précipitations.

L’apport de l’apprentissage profond

La France bénéficie d’un maillage exceptionnel de radars et de prévisions météorologiques très fiables. « Le potentiel est riche pour ce qui touche au nowcasting », détaille Aymeric Chazottes. Cela désigne les prévisions à très court terme, par exemple pour anticiper la nécessité d’évacuer des zones en cas de fortes pluies. La priorité est alors donnée à des modèles rapides capables de fournir des projections quasi instantanées, au coût de leur précision. L’apport des réseaux de neurones est parfaitement adapté à cet exercice car ils permettent d’apprendre un volume massif de données et de fournir des estimations en un temps réduit.

Ces modèles comportent aussi de nombreux paramètres et méta-paramètres. Le chercheur explique que « les modèles neuronaux ne sont pas forcément entraînés par des spécialistes de la météorologie. Il est crucial de favoriser les échanges entre disciplines et d’aider les expertes et experts en apprentissage automatique à intégrer les ordres de grandeur propres à la météorologie pour optimiser la paramétrisation et l’entraînement des modèles, et d’accompagner les météorologues dans le choix des outils numériques les plus adaptés à leurs questions et à leurs projets ».

Par ailleurs, les réseaux de radars restent coûteux à déployer et à entretenir. Pour des enjeux globaux, il est donc aussi nécessaire d’explorer d’autres types d’approches. Cela s’illustre par un projet opportuniste d’évaluation quantitative des précipitations, exploitant des satellites géostationnaires associés à un algorithme de restitution.

Un levier pour la recherche appliquée

Les données fournies par les satellites et les modèles d’apprentissage automatique constituent des ressources précieuses pour prédire les impacts d’évènements climatiques extrêmes sur l’agriculture et identifier des stratégies d’adaptation au changement climatique. David Makowski, chercheur au laboratoire Mathématiques et informatiques appliquées – Paris-Saclay (MIA-PS - Univ. Paris-Saclay/INRAE/AgroParisTech), a collaboré sur un projet visant à exploiter les données satellitaires grâce aux réseaux de neurones profonds pour prévoir les récoltes de maïs aux États-Unis et dans plusieurs pays africains. « Certaines régions du monde, comme l’Afrique, dépendent fortement de cette céréale et la mise à disposition de ces outils peut changer la donne », explique-t-il. L’impact de ce type de prévision est potentiellement immense, d’autant plus que les données satellitaires utilisées dans ce projet sont gratuites.

Les déclinaisons possibles sont multiples, telles que prédire le prix des matières premières agricoles, et s’avèrent particulièrement efficaces pour optimiser les stratégies d’adaptation au changement climatique. Le chercheur du laboratoire MIA Paris-Saclay rappelle que « dans des systèmes qui impliquent des effets non linéaires et des interactions multiples, les méthodes statistiques simples, comme la régression linéaire, atteignent vite leurs limites ». Au contraire, les techniques d’apprentissage automatique sont mobilisables sur des projets ambitieux, combinant de multiples objectifs, comme l’optimisation de l’allocation des exploitations de soja en Europe. Un problème complexe qui répond à un enjeu réel de concilier les objectifs de production élevée et de résilience aux aléas climatiques, tout en réduisant la dépendance européenne au soja produit en Amérique du Sud - aujourd’hui principal fournisseur de soja destiné à l’alimentation animale en Europe.

Dans ce type de problématique complexe, l’apprentissage automatique apporte un avantage décisif : il ne nécessite pas de formuler une équation précise ou d’anticiper toutes les interactions possibles. L’apprentissage automatique mobilise un large éventail d’algorithmes et de configurations, conservant la souplesse des approches non paramétriques tout en offrant de bonnes capacités de prédiction. Une flexibilité précieuse dans ce genre de contexte.

Un potentiel d’applications infini

La dernière décennie a été marquée par l’essor de nouveaux algorithmes et par une puissance de calcul sans précédent. Cette combinaison apporte de nouvelles opportunités aux scientifiques : une « boîte à outils » beaucoup plus riche, capable de produire des prédictions plus fiables et applicables à des domaines variés, souvent liés à des enjeux très concrets. Selon David Makowski, « un des grands enjeux des prochaines années est d’identifier des zones de vulnérabilité au changement climatique - les hotspots - afin de mieux préparer l’adaptation ». Les outils numériques sont à-même d’évaluer de multiples formes de vulnérabilité, qu’elles concernent les infrastructures, les écosystèmes ou les populations, pour guider la planification des mesures d’adaptation.

« Dans l’agriculture, le potentiel est immense » ajoute David Makowski. Il cite l’exemple du riz : cette culture, essentielle à l’alimentation humaine, supporte mal les températures trop élevées. En utilisant un algorithme d’apprentissage de type « forêt aléatoire », le chercheur a évalué quantitativement les effets du changement climatique (sécheresses, températures élevées) sur la qualité du riz et identifié des stratégies d’adaptation. Il souligne que « quel que soit le projet, l’enjeu est de savoir si les prédictions sont précises ou non. Pour choisir le meilleur algorithme, il faut tester différents algorithmes prédictifs à l’aide de données solides ». Selon lui, l’apprentissage automatique répond à un besoin de la communauté scientifique, mais au prix d’une puissance de calcul élevée qui a un coût énergétique parfois important.

Devenues aujourd’hui des outils indispensables, les méthodes numériques ouvrent également la voie à de nouveaux domaines, comme la science de l’attribution : un champ d’étude particulièrement utile au niveau sociétal, qui analyse dans quelle mesure les événements extrêmes sont attribuables au changement climatique. « Et cette évolution technique ne s’applique pas seulement aux géosciences, l’utilisation des méthodes numériques en économie et en sociologie bouleverse considérablement les méthodes des chercheurs et chercheuses en sciences sociales. C’est dans ces disciplines que nous verrons des impacts majeurs dans les prochaines années », complète David Makowski. Il serait désormais difficile d’imaginer le monde de la recherche sans ces outils pour améliorer la connaissance globale du système Terre et de son évolution future, concevoir et optimiser des stratégies d’adaptation au changement climatique, ou encore anticiper les risques et renforcer la résilience des systèmes socio-écologiques face à un avenir incertain.

Références :

- Lloret Z, Chevallier F, Cozic A. Refining the Global Picture: The Impact of Increased Resolution on CO2 Atmospheric Inversions Using OCO-2 XCO2 Retrievals. J Geophys Res Atmos. 2024, 129 (22), e2024JD041016.

- Chevallier, F., Lloret, Z., Cozic, A., Takache, S., & Remaud, M. Toward high-resolution global atmospheric inverse modeling using graphics accelerators. Geophysical Research Letters, 2023, 50, e2022GL102135.

- Gonzalez P., Naveau P., Thao S., Worms J. A Statistical Method to Model Non-stationarity in Precipitation Records Changes. Geophysical Research Letters, 2025, 52 (6), e2023GL107201.

- Vrac M., Allard D., Mariéthoz G., Thao S., Schmutz L. Distribution-based pooling for combination and multi-model bias correction of climate simulations. Earth System Dynamics, 2024, 15 (3), pp. 735-762.

- Faranda D., Messori G., Bourdin S., Vrac M., Thao S., Riboldi J., Fromang S., Yiou P. Correcting biases in tropical cyclone intensities in low-resolution datasets using dynamical systems metrics. Climate Dynamics, 2023, 61 (9-10), pp. 4393-4409.

- Gelbart, L., Barthès, L., Mercier-Tigrine, F., Chazottes, A., and Mallet, C. Enhanced quantitative precipitation estimation through the opportunistic use of Ku TV-SAT links via a dual-channel procedure, Atmos. Meas. Tech., 2025, 18, 351-370.

- Guigal B., Barthes L., Chazottes A., Viltard N., Le Bouar E., Moreau E., Mallet C. Meta-Analysis of Rain Nowcasting Using Machine Learning and Non-Machine Learning Models. International Geoscience and Remote Sensing Symposium (IGARSS), 2024, pp. 5534 – 5538.

- Dilmi, M.D., Barthès, L., Mallet, C. et al. Iterative multiscale dynamic time warping (IMs-DTW): a tool for rainfall time series comparison. Int J Data Sci Anal, 2020, 10, 65-79.

- Shuhui Han, Xianfeng Liu, David Makowski, Philippe Ciais, Meta-analysis of water stress impact on rice quality in China, Agricultural Water Management, 2025, Volume 307, 109230, ISSN 0378-3774.

- Mathilde Chen, David Makowski, and Alberto Tonda. Multi-Objective Optimization for Large-scale Allocation of Soybean Crops. In Proceedings of the Genetic and Evolutionary Computation Conference (GECCO '24). Association for Computing Machinery, 2024, 1174-1182.

- Florian Teste, David Makowski, Hassan Bazzi, Philippe Ciais, Early forecasting of corn yield and price variations using satellite vegetation products, Computers and Electronics in Agriculture, 2024, Volume 221, 108962, ISSN 0168-1699.