Ambitions quantiques : positionner la France à la pointe des technologies

(Cet article est issu de L'Édition n°18)

Tour d’horizon de quelques projets intégrés à la stratégie quantique nationale auxquels sont associés les chercheurs et chercheuses de l’Université Paris-Saclay.

Comme l’annonçait la présidente de l’Université Paris-Saclay, Sylvie Retailleau, en préambule de la conférence « Ambitions quantiques : renforcer le leadership de Europe » organisée le 21 février 2022 dans le cadre de la présidence française de l’Union européenne : « le développement des technologies quantiques est aujourd’hui à la croisée des chemins, entre opportunités et défis ».

Avec leur fort potentiel de rupture et de transformation économique ou sociétale, les technologies quantiques représentent un domaine de recherche des plus compétitifs, à l’interface entre recherche fondamentale et appliquée. Qu’il s’agisse de nouvelles approches en physique des hautes énergies, de chimie quantique, d’informatique quantique, de cryptographie quantique ou encore de capteurs quantiques, leurs possibles retombées expliquent que ces technologies fassent l’objet d’une intense course mondiale où se côtoient laboratoires de recherche, start-up émergentes et géants du numérique.

Une stratégie nationale dédiée

Intégré au Plan quantique – la stratégie française quantique – lancé par le Président de la République Emmanuel Macron le 21 février 2021 depuis le plateau de Saclay, le Programme et équipements prioritaires de recherche (PEPR) Technologies quantiques est un des premiers dispositifs créés en soutien de recherches, au meilleur niveau mondial, réalisées dans ce domaine. Piloté par le CEA, le CNRS et Inria, il a pour objectif de positionner la France à la pointe des développements et d’assoir le leadership français.

Avec son enveloppe de 150 millions d’euros, il vient soutenir des projets tournés vers six axes : les simulateurs et les accélérateurs quantiques, le passage à l’échelle de l’ordinateur quantique, les capteurs quantiques, la cryptographie post-quantique, les communications quantiques et les technologies habilitantes. Le dispositif poursuit également quatre axes transverses qui sont le développement du capital humain, le renforcement des infrastructures technologiques, l’amélioration de l’environnement entrepreneurial, et le renforcement de l’interdisciplinarité et de la prise de risque dans la recherche amont. Début mars 2022, dix premiers projets impliquant des laboratoires et des start-up issus des pôles quantiques de Paris-Saclay, Grenoble et Paris-centre, et deux équipements structurants EquipEx+ ont été retenus pour financement. Les chercheurs et chercheuses de l’Université Paris-Saclay sont impliquées dans sept de ces projets et dans l’EquipEx+ e-DIAMANT, piloté par l’École normale supérieure Paris-Saclay et qui doit créer toute la chaîne de fabrication de diamants destinés à des applications quantiques.

Qubits et information quantique

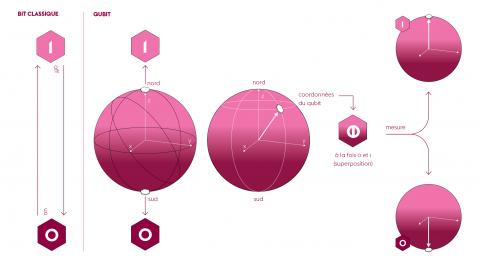

Point névralgique des recherches, le qubit est l’homologue quantique du bit de l’informatique traditionnelle. Si ce dernier transcrit une information de façon binaire (0 ou 1), selon le passage (ou non) d’un courant électrique et la circulation de charges électriques dans le système, le qubit, lui, est généré par des objets quantiques (atomes, particules, spins…) intégrés au système et son état (ou sa valeur) est loin d’être aussi tranché. Cet état est défini comme une superposition de l’état 0 et 1, et est donné par une équation mathématique qui démontre une infinité de valeurs possibles.

Dès lors, l’information logée dans les qubits se révèle d’une grande richesse. C’est cette richesse qui est à l’origine de l’enthousiasme autour de l’ordinateur quantique, dont les capacités de calcul s’annoncent décuplées. Dans un tel système, les opérations de calcul s’effectuent en agissant sur les qubits au moyen de dispositifs physiques. Or tout le problème est là. La superposition quantique, et plus généralement les effets quantiques, sont fragiles et très sensibles à l’environnement et aux perturbations extérieures qui affectent inévitablement les systèmes physiques. Elle peut rapidement être perdue et entraîner la décohérence des qubits. Cette décohérence les rend illisibles et cela influe sur l’information quantique : elle est détériorée par l’accumulation d’erreurs aléatoires.

L’importance de la cohérence

Un des enjeux est de réussir à prolonger au maximum la cohérence des qubits, c’est-à-dire leur stabilité et la durée pendant laquelle il est possible d’effectuer des calculs. Pour ce faire, plusieurs types de qubits sont à l’étude. Leurs caractéristiques varient en fonction de la nature de l’objet quantique sur lequel ils s’appuient : supraconducteurs, atomes piégés, photons, spins nucléaires, spins d’électrons, etc. Pourtant, malgré les multiples annonces concernant le nombre toujours plus important de qubits atteints par les processeurs quantiques développés par les géants industriels, il n’existe toujours pas d’architecture matérielle capable d’engendrer des qubits protégés contre la décohérence.

Pour lutter contre elle, l’approche la plus répandue est de faire appel à la redondance : au lieu de n’être codée que dans un seul qubit, l’information quantique est inscrite dans un grand nombre de qubits. Ces qubits « physiques », qui forment un qubit « logique » ou « protégé », préservent l’information quantique. Quoique prometteuse, cette approche nécessite un très grand nombre de qubits physiques pour former un seul qubit logique. Or les prédictions les plus optimistes s’accordent sur le fait qu’il faut disposer de 1 000 qubits physiques afin d’obtenir 1 qubit logique et réussir à faire tourner des algorithmes pourtant faiblement demandeurs, avec des taux d’erreurs de moins de 1 % sur toutes les opérations.

Des qubits plus robustes pour le calcul quantique

Le projet RobustSuperQ vise justement à accélérer la R&D française sur les qubits supraconducteurs et hybrides protégés, par construction, contre la décohérence. Il envisage, dans les cinq prochaines années, de développer des qubits supraconducteurs de nouvelle génération et de mettre au point un nouveau type de processeur quantique, corrigé, de haute-fidélité, pilotable et mesurable, et composé de qubits physiques très robustes, dont un petit nombre forme un qubit logique.

En collaboration avec l’ensemble des acteurs académiques et privés (dont l’industriel ATOS et les start-up C12 et Alice & Bob) de la communauté des circuits quantiques, les groupes Quantronique et Nanoélectronique du Service de physique de l’état condensé (SPEC – UPSaclay, CEA, CNRS), les équipes de l’Institut de physique théorique (IPhT – UPSaclay, CNRS, CEA) et Théorie du Laboratoire de physique des solides (LPS – UPSaclay, CNRS) exploreront en parallèle trois pistes de développement : les qubits dits « de chat » stabilisés dynamiquement, une architecture hybride à base de spins électronucléaires très cohérents couplés magnétiquement à des circuits supraconducteurs, et les qubits supraconducteurs protégés topologiquement contre la décohérence.

Vers de nouveaux simulateurs quantiques

Si l’ordinateur quantique universel est aujourd’hui encore lointain, des plateformes sont déjà capables de réaliser des simulations quantiques complexes et inaccessibles aux méthodes de calcul classiques. Certaines s’appuient sur des matrices d’atomes piégés par un système de « pinces optiques » et mis en interaction par un laser les plongeant dans un niveau d’excitation très élevé dit « état de Rydberg ». D’autres utilisent des atomes ultra-froids – refroidis à des températures très proches du zéro absolu (0 K ou -273,15 °C) – en interaction dans des réseaux optiques par faisceaux laser.

L’objectif du projet QubitAF est d’améliorer ces deux types de plateformes en augmentant le nombre d’atomes manipulés, et de caractériser et certifier les résultats. Les trois groupes expérimentateurs impliqués, dont le Laboratoire Charles Fabry (LCF – UPSaclay, IOGS, CNRS), et la start-up Pasqal issue du LCF auront pour mission de développer une nouvelle génération de simulateurs de Rydberg et de nouveaux types de simulateurs à atomes froids. Il s’agit également de mettre au point de nouveaux outils pour diagnostiquer les propriétés quantiques de ces systèmes, telles que l’intrication ou les corrélations quantiques.

Améliorer la tolérance aux fautes

Si disposer d’un grand nombre de qubits et d’une cohérence suffisamment longue sont des éléments importants, il faut également que le système soit en capacité de maintenir un faible taux d’erreurs. Cela passe par l’implantation de routines de correction d’erreurs : des codes correcteurs. Leur rôle est de délocaliser l’information quantique d’une partie du système vers d’autres systèmes physiques, pour mieux la protéger du bruit environnant.

Au sein du projet NISQ2LSQ, la vingtaine d’équipes académiques impliquées, dont Quantronique du SPEC et celles du LCF et du Centre de nanosciences et de nanotechnologies (C2N – UPSaclay, CNRS, Univ. de Paris), et les start-up Alice&Bob et Quandela issue du C2N, ont pour ambition de mettre au point de nouvelles stratégies de correction d’erreurs efficaces et d’obtenir par là des ordinateurs quantiques tolérants aux fautes. Les recherches se tourneront vers les codes bosoniques, les codes photoniques et les codes LDPC (Low-Density Parity-Check), qui seront explorés sur deux types de plateformes physiques : les circuits supraconducteurs et les circuits photoniques. D’ici cinq ans, les partenaires ambitionnent de réaliser un prototype de processeur quantique supraconducteur à base des qubits de chat, plus tolérant aux fautes, de définir des architectures de calcul fondées sur la mesure exploitant les codes photoniques et de déterminer les éléments nécessaires à leur construction.

Des algorithmes quantiques plus efficaces et élargis

Pour obtenir un réel avantage quantique, il ne suffit pas de construire une machine fonctionnant selon les principes quantiques, il faut aussi développer des algorithmes efficaces, exploitant les spécificités de la mécanique quantique et capables de résoudre efficacement les problèmes. Un des défis est de proposer de nouvelles techniques algorithmiques dont l’avantage est réel et prouvé, mais aussi d’enrichir les domaines d’application potentiels du traitement quantique de l’information.

Plus d’une vingtaine de partenaires académiques et privés travailleront au sein du projet EPiQ à développer des algorithmes quantiques dans les domaines de l’optimisation, l’apprentissage machine, la simulation de systèmes physiques ou la chimie, tant pour des machines NISQ (Noisy Intermediate-Scale Quantum) – comportant 50 à 100 qubits sans correction d’erreur fiable mais capables d’effectuer des tâches supérieures aux ordinateurs classiques – que pour des machines tolérantes aux fautes. L’équipe-projet QUACS du Laboratoire méthodes formelles (LMF – UPSaclay, CNRS, ENS Paris-Saclay, CentraleSupélec, Inria), les équipes du Laboratoire d’intégration de systèmes et de technologies (List – UPSaclay, CEA), du Laboratoire interdisciplinaire des sciences du numérique (LISN – UPSaclay, CEA, CNRS) et de l’IPhT s’attacheront à mettre au point de nouveaux algorithmes quantiques, à mieux définir les architectures et les langages des machines actuelles, et à les simuler pour mieux les comprendre.

Cryptographie et communication quantiques : mieux résister aux attaques

Avec les progrès liés au calcul quantique, c’est tout le domaine de la cryptographie et de la sécurité des communications qui sont remises en question, notamment le web et son protocole TLS (le cadenas des navigateurs). Alors que cette sécurité repose sur la robustesse d’algorithmes cryptographiques difficiles à résoudre par un ordinateur classique, elle n’opposerait que peu de résistance face à un ordinateur quantique. Devant ces menaces, les partenaires du projet PQ-TLS, dont le Laboratoire de mathématiques de Versailles (LMV – UPSaclay, UVSQ, CNRS) et le LMF, ont pour objectif de développer de nouveaux schémas de chiffrement et de signature pour faire passer la cryptographie à l’ère post-quantique et rendre les protocoles résistants aux attaques.

La distribution quantique de clés repose par ailleurs essentiellement sur une hypothèse : celle que les appareils employés réalisent exactement les opérations prévues par les protocoles. Un élément difficile à vérifier en pratique. L’objectif du projet DIQKD, qui comprend notamment une équipe de l’IPhT, est de réaliser le premier prototype de distribution quantique de clés de type « boîte noire », capables de garantir, pour des appareils peu ou partiellement caractérisés, une confidentialité sans précédent des communications sur une distance plus importante, et de résister aux attaques quantiques. De son côté, le projet QcommTestbed, auquel le C2N prend part, vise à doter les équipes académiques et industrielles d’une infrastructure nationale d’essais flexible et évolutive pour des applications de communication quantique. Ce banc d’essai sera utilisé pour franchir les étapes successives entre les démonstrations en laboratoire, les prototypes sur le terrain et les produits commerciaux.

Autant d’éléments qui doivent faire basculer le développement des technologies quantiques vers une nouvelle ère.

Anticiper la réponse de l’ordinateur quantique

À l’IJCLab, Denis Lacroix et son équipe conçoivent des algorithmes capables de décrire des ensembles de particules en interaction et testent leurs calculs en anticipant les futurs ordinateurs quantiques.

Physicien théoricien au Laboratoire de physique des deux infinis – Irène Joliot-Curie (IJCLab – UPSaclay, CNRS, Univ. de Paris), Denis Lacroix étudie les interactions fortes entre protons et neutrons des noyaux atomiques, qu’il modélise généralement sur des ordinateurs classiques. « Mais avec un grand nombre de particules en interaction, les matrices atteignent vite des dimensions critiques et explosent », signale le chercheur. Des limites qui s’effacent potentiellement avec l’ordinateur quantique.

Avec son équipe, Denis Lacroix analyse de quelle manière il sera possible d’utiliser ces machines. « On prépare l’avenir, pour le jour où elles seront prêtes. » Le chercheur met au point des méthodes et des algorithmes destinés à résoudre des problèmes auxquels les ordinateurs classiques ne peuvent s’attaquer. Dans ses derniers travaux, il s’est intéressé au spin total d’un système à n corps. « On a mis au point un algorithme capable de trier le spin total d’un ensemble de particules, c’est-à-dire de filtrer ce système désordonné pour ne retenir que les spins qui sont dans une orientation donnée. » Il a également cherché à calculer l’énergie d’un système quantique dans différents états. « La méthode est itérative et hybride : on fait varier les paramètres du système sur un ordinateur classique, puis on calcule sur un ordinateur quantique quelle est son énergie grâce à une fonction d’onde qu’on a préparée, et on réajuste les paramètres au fur et à mesure. »

Pour tester les algorithmes mis au point, le chercheur utilise un émulateur d’ordinateur quantique mis gratuitement à disposition par IBM via un cloud. « On fait “comme si” on travaillait avec un vrai ordinateur quantique, sans en avoir les derniers développements. » Pour la suite, le chercheur envisage de pousser à son maximum la description des noyaux : « il s’agit d’aller vers des noyaux de plus en plus grands, et de voir comment le système évolue, vibre, bouge et va jusqu’à la fission ».

Publication :

- Guzman E. A. R., Lacroix D. Accessing ground-state and excited-state energies in a manybody system after symmetry restoration using quantum computers. Phys. Rev. C 105, 024324, (2022).

Un détecteur de photons micro-ondes des plus sensibles

Au Service de physique de l’état condensé (SPEC – UPSaclay, CEA, CNRS), Emmanuel Flurin et ses collègues repoussent les limites de la résonance magnétique avec un ingénieux compteur de photons micro-ondes capable de détecter un très faible nombre de spins électroniques.

Le dispositif mis au point par les scientifiques du SPEC combine circuits quantiques supraconducteurs et spins d’électrons dans des solides, et s’applique à des températures cryogéniques. Le spin est un système à deux niveaux quantiques distincts – fondamental et excité –, qui passe d’un état à l’autre via l’absorption/ l’émission d’un photon unique dont l’énergie est dans le domaine micro-onde. La désexcitation ne se faisant spontanément qu’après un temps très long, il est possible de l’accélérer grâce à une cavité résonante supraconductrice. Les photons émis sont alors collectés par le compteur de photon micro-onde, constitué d’un qubit supraconducteur capable d’absorber le photon de manière irréversible. La mesure ultérieure du qubit dans son état excité signale la présence du photon et se traduit par un click du détecteur. « Compter les spins, ça revient à lire le qubit supraconducteur dans son état excité », résume Emmanuel Flurin. L’équipe a récemment apporté une preuve de principe en détectant un petit ensemble de spins électroniques dans du silicium.

Le projet INGENIOUS, lauréat d’une ERC Starting Grant en 2021 et porté par le chercheur, s’inscrit dans la continuité de ces recherches. « On souhaite développer de nouvelles générations de compteurs de photons capables d’atteindre une sensibilité suffisante pour détecter un spin électronique individuel. » Cela ouvrirait à des applications en informatique quantique. Les travaux se tourneront vers les spins électroniques d’ions erbium (Er3+) dans un cristal d’oxyde de tungstène, dont l’équipe a récemment observé des temps de cohérence de 23 ms. « Si on parvient à manipuler un spin électronique individuel, on peut aussi le faire avec ses voisins, les spins nucléaires, dont les temps de cohérence sont potentiellement encore plus longs. »

Publication :

- Albertinale, E. et al. Detecting spins by their fluorescence with a microwave photon counter. Nature 600, 434–438 (2021).